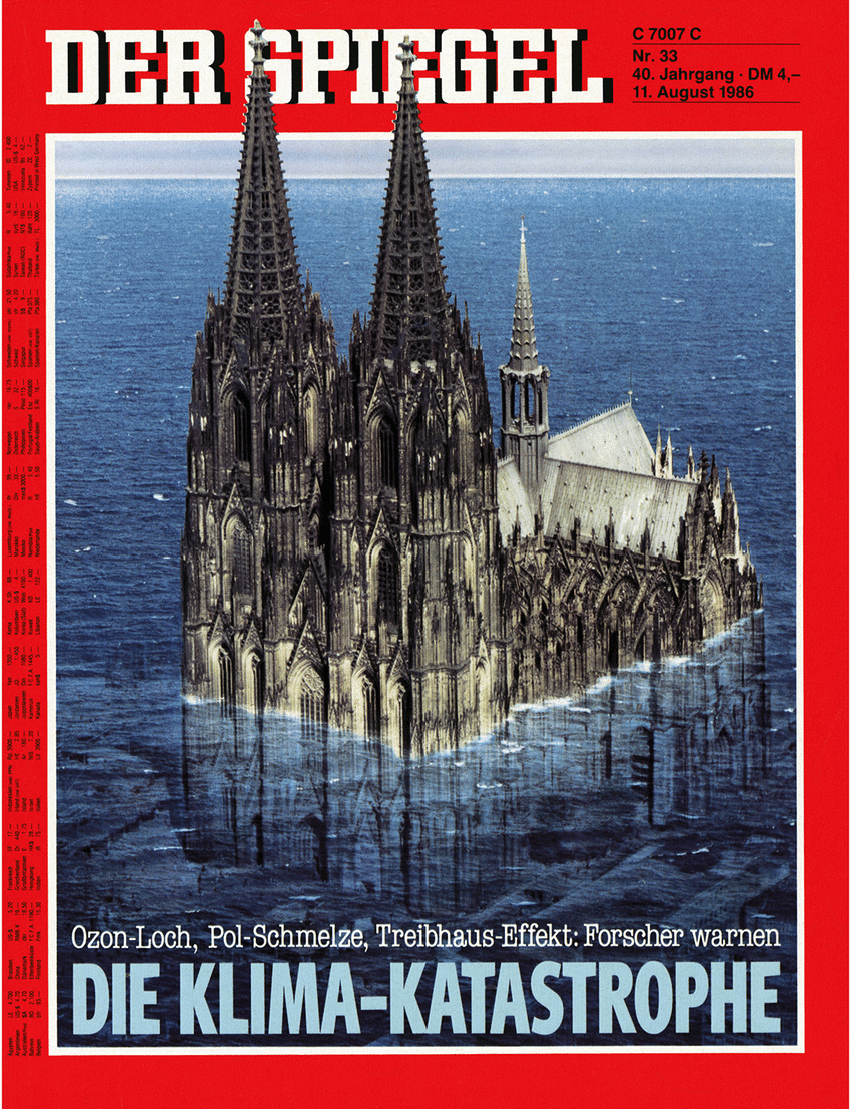

Unsere unsichere Klimazukunft

Alle Aussagen der Klimawissenschaft über die Zukunft beruhen auf Computermodellen. Doch deren Ergebnisse driften weit auseinander.

Read the English version here.

Die menschlichen Einflüsse auf das Klima sind physikalisch gesehen gering – sie verschieben die Energieflüsse des Planeten nur um etwa 1 Prozent. Das bedeutet nicht, dass wir sie ignorieren können, denn das Klimasystem ist empfindlich. Aber es vergrössert die Herausforderung, zu verstehen, wie das Klima in Zukunft aussehen wird.

Die Computermodellierung ist für diese Aufgabe von zentraler Bedeutung. Die Modelle helfen uns zu verstehen, wie das Klimasystem funktioniert, warum es sich in der Vergangenheit verändert hat und – was am wichtigsten ist – wie es sich in Zukunft unter natürlichen und wachsenden menschlichen Einflüssen verändern könnte. Aber grundlegende Umstände schränken die Fähigkeit der Modelle ein, das Klima der Erde sinnvoll zu beschreiben. Um zu verstehen, warum das so ist, müssen wir ein wenig in die Details gehen.

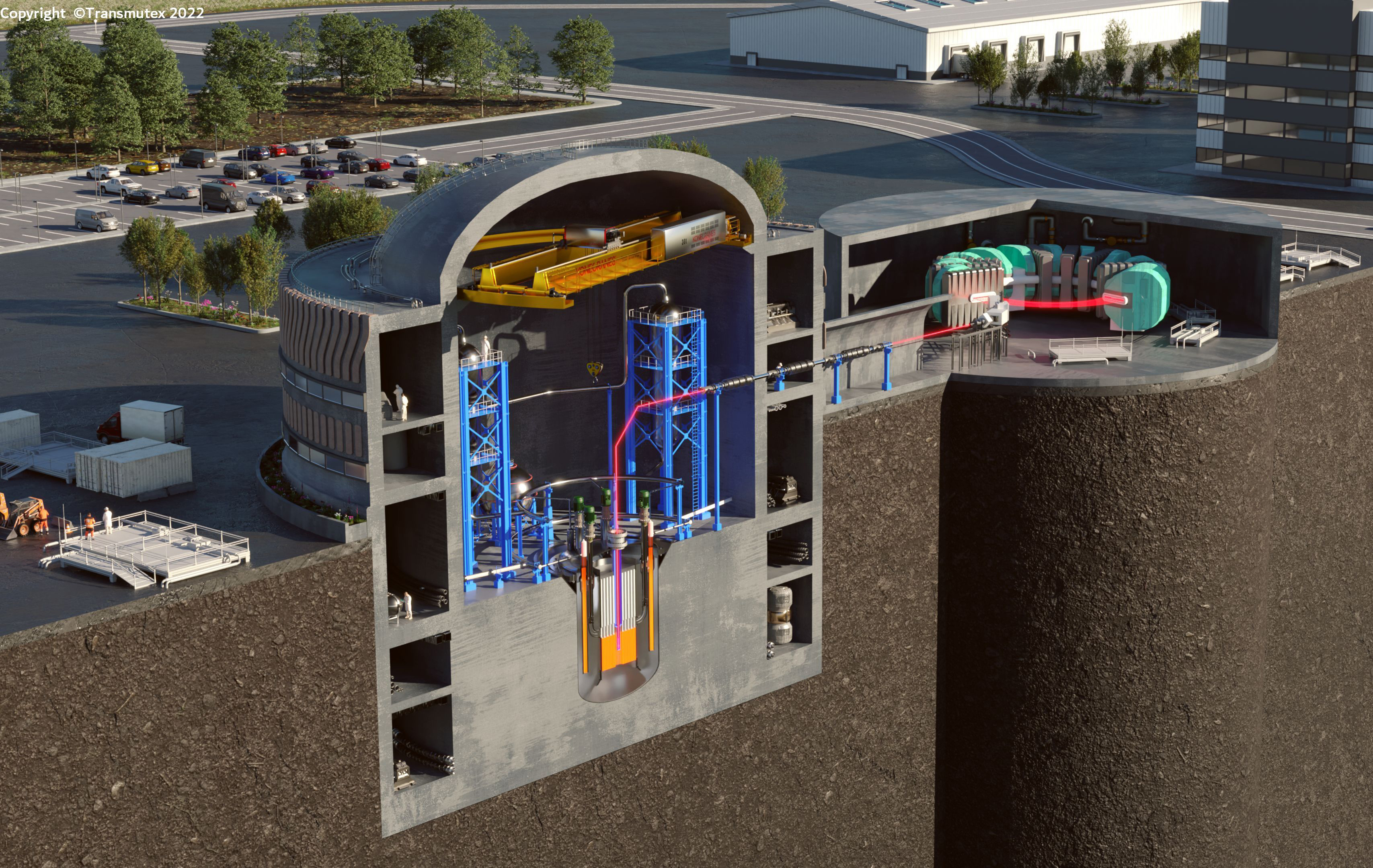

Alle ausser den einfachsten Computermodellen des Klimas beginnen damit, dass die Landoberfläche der Erde mit einem Gitter aus Quadraten abgedeckt wird, die in der Regel eine Seitenlänge von 100 km haben. Um die Atmosphäre zu beschreiben, werden 10–20 Schichten von Gitterboxen über diese Quadrate gestapelt. Mit einem ähnlichen, aber feineren Gitter, das den Ozean abdeckt, umfasst das Modell eine Million Gitterboxen für die Atmosphäre und 100 Millionen Gitterboxen für den Ozean.

Monatelange Berechnungen durch Supercomputer

Die Computermodelle nutzen die grundlegenden Gesetze der Physik, um zu berechnen, wie sich Luft, Wasser und Energie in jedem Feld zu einem bestimmten Zeitpunkt zu den benachbarten Gitterfeldern zu einem etwas späteren Zeitpunkt bewegen; dieser Zeitschritt kann so klein wie 10 Minuten sein. Durch millionenfache Wiederholung dieses Prozesses wird das Klima für Jahrhunderte simuliert, eine Berechnung, die selbst auf den leistungsfähigsten Supercomputern Monate an Rechenzeit in Anspruch nehmen kann. Vergleicht man die Ergebnisse der Computerläufe mit dem, was wir über das Klima in der Vergangenheit wissen, erhält man ein Gefühl dafür, wie gut ein Modell ist. Berechnungen in die Zukunft unter der Annahme menschlicher und natürlicher Einflüsse geben dann vor, das Klima in den nächsten Jahrzehnten zu beschreiben.

Das klingt zwar einfach, ist es aber leider nicht. Ein grosses Problem ist, dass viele wichtige Phänomene viel kleiner sind als das Gitter der Quadrate mit einer Seitenlänge von 100 Kilometern. So wird beispielsweise der Fluss von Sonnenlicht und Wärme durch die Atmosphäre von Wolken beeinflusst. Da es viel zu viele Wolken gibt, um jede einzelne im Detail zu verfolgen, müssen die Forscher «Untergitter»-Annahmen über die Anzahl und Art der Wolken in jedem Gitterfeld treffen, um ein vollständiges Modell zu erstellen. Die Wolkenbedeckung ist nur eine von Dutzenden von Untergitterannahmen. Eine weitere ist die Frage: Wie viel Schnee oder Eis liegt auf der Oberfläche, die die Heizwirkung des Sonnenlichts steuert?

Jede Untergitterannahme hat numerische Parameter, die auf irgendeine Weise festgelegt werden müssen. Die Modellierer bestimmen die Untergitterparameter auf der Grundlage ihres Wissens über Physik, Wetter- und Klimabeobachtungen und lassen dann das Modell laufen. Da die Ergebnisse in der Regel nicht mit dem von uns beobachteten Klimasystem übereinstimmen, passen («tunen») die Modellierer diese Parameter an, um einige Merkmale des realen Klimasystems besser zu berücksichtigen. Verschiedene Modellierer gehen von unterschiedlichen Annahmen und Einstellungen aus und kommen so zu höchst unterschiedlichen Ergebnissen.

Diese Anpassungen sind ein notwendiger, aber gefährlicher Teil der Klimamodellierung, wie bei der Modellierung jedes komplexen Systems. Ein schlecht abgestimmtes Modell wird die reale Welt nur unzureichend beschreiben, während eine zu starke Justierung das Risiko birgt, dass man die Ergebnisse frisiert, d.h. die Antwort im Voraus festlegt. In einem Forschungspapier1, in dem die Details eines der angesehensten Modelle des deutschen Max-Planck-Instituts beschrieben werden, heisst es zum Beispiel, dass ein Untergitterparameter (der mit der Konvektion in der Atmosphäre zusammenhängt) um den Faktor zehn angepasst wurde, weil der ursprünglich gewählte Wert zu einer doppelt so starken Erwärmung führte, wie beobachtet worden war. Einen Subgrid-Parameter um den Faktor zehn von dem zu ändern, was man dachte – das ist wirklich ein Dreh an den Reglern!

Rückkoppelungen sind tückisch

Um nützliche Informationen aus sehr unterschiedlichen Modellen zu gewinnen, werden die Ergebnisse in der Regel als Durchschnittswerte für eine Sammlung («Ensemble») von Modellen angegeben; bei den jüngsten IPCC-Bewertungen der UN wurde das CMIP6-Ensemble verwendet2. Die Vielfalt dieses Ensembles zeigt sich bereits in einer der einfachsten Beschreibungen des Klimas – der durchschnittlichen Oberflächentemperatur der Erde. Sie variiert innerhalb des Ensembles um etwa 3º C, dreimal so viel wie die beobachtete Erwärmung während des 20. Jahrhunderts. Und die Modelle unterscheiden sich ebenso deutlich, wenn man sich die Details ihrer Ergebnisse ansieht. Da man beispielsweise die Gefriertemperatur von Wasser nicht einstellen darf (da sie von der Natur vorgegeben ist), können die Mengen an Schnee und Eis bei Modellen mit unterschiedlichen Oberflächentemperaturen sehr unterschiedlich ausfallen. Dies lässt sich an den Unterschieden zwischen dem von der nördlichen und der südlichen Hemisphäre absorbierten Sonnenlicht in den CMIP6-Modellen ablesen. Es ist beunruhigend, dass die Spannweite sowohl im Vergleich zu den beobachteten Werten als auch zu den aktuellen menschlichen Einflüssen gross ist.

Es wäre zwar beruhigend, wenn die Modelle in der Lage wären, das gegenwärtige Klima genau zu beschreiben, aber für die Gesellschaft ist es entscheidend, wie gut sie die Reaktion des Klimas auf physikalisch kleine menschliche Einflüsse wie erwärmende Treibhausgase, abkühlende Aerosole und Änderungen der Landnutzung beschreiben. Das Wichtigste, was ein Modell hier richtig machen muss, sind die «Rückkopplungen».

Rückkopplungen funktionieren folgendermassen: Die zunehmenden Treibhausgaskonzentrationen, die die globale Temperatur erhöhen, können auch andere Veränderungen im Klimasystem verursachen, die ihren direkten Erwärmungseinfluss entweder verstärken oder unterdrücken. Wenn sich der Globus beispielsweise erwärmt, gibt es weniger Schnee und Eis auf der Oberfläche, wodurch das Reflexionsvermögen des Planeten sinkt. Die weniger reflektierende Erde wird dann mehr Sonnenlicht absorbieren, was zu einer noch stärkeren Erwärmung führt. Andere wichtige Rückkopplungen betreffen die Menge an Wasserdampf und Wolken in der Atmosphäre oder das Temperaturprofil der Atmosphäre. Der Durchschnitt der Ergebnisse der vielen verschiedenen Modelle in den Ensembles deutet darauf hin, dass der Nettoeffekt aller Rückkopplungen den direkten Erwärmungseinfluss von CO2 verdoppeln oder verdreifachen wird.

Das Ausmass oder in einigen Fällen sogar das Vorzeichen dieser Rückkopplungseffekte – das heisst, ob sie zu einer Nettoerwärmung oder einer Nettokühlung führen – kann nicht von vornherein genau genug verstanden werden, sondern muss sich aus einem Modell ergeben, während es angepasst wird, und jedes Modell wird etwas andere Antworten liefern. Ein gängiges Mass dafür, wie das Klimasystem auf menschliche Einflüsse reagiert, und eine wichtige Information, die wir uns von den Modellen erhoffen, ist zum Beispiel die Gleichgewichtsklimaempfindlichkeit (Equilibrium Climate Sensitivity, ECS). Sie gibt an, um wie viel die durchschnittliche Oberflächentemperatur ansteigen würde, wenn die CO2-Konzentration gegenüber dem vorindustriellen Wert verdoppelt würde. Wenn die Emissionen in ihrem derzeitigen Tempo weitergehen und sich der Kohlenstoffkreislauf nicht wesentlich ändert, würde diese Verdopplung in der realen Welt gegen Ende dieses Jahrhunderts eintreten. Je höher der ECS (d.h. je grösser der vorhergesagte Temperaturanstieg), desto empfindlicher reagiert das Klima auf menschliche Einflüsse (oder zumindest auf eine Zunahme des CO2).

Die ECS-Werte von 37 Modellen des CMIP6-Ensembles zeigen, dass etwa ein Drittel der Modelle zu einem simulierten Klima führt, das empfindlicher ist als die vom IPCC zuvor angegebene wahrscheinliche Obergrenze von 4,5º C. Der jüngste IPCC-Bericht milderte diese Peinlichkeit ab, indem er die Ensemblewerte mit Beobachtungen der einzelnen beteiligten Rückkopplungsprozesse kombinierte, um zu schätzen, dass ECS wahrscheinlich im Bereich von 2,5–4,0º C liegt.

Die Bandbreite der Empfindlichkeiten in den Modellensembles ist in dem Masse gewachsen, wie die Modelle ausgefeilter wurden – einschliesslich feinerer Gitter, ausgefeilterer Untergitterparametrisierungen und so weiter. Mit besseren Werkzeugen und Informationen sollten die Modelle genauer werden und besser miteinander übereinstimmen. Dass dies nicht geschehen ist, sollten Sie bedenken, wenn Sie lesen: «Modelle sagen voraus …». Die Tatsache, dass die Bandbreite der Ergebnisse zunimmt, ist ein guter Beweis dafür, dass «die Wissenschaft» noch lange nicht abgeschlossen ist.

Nicht alle Modelle stimmen überein

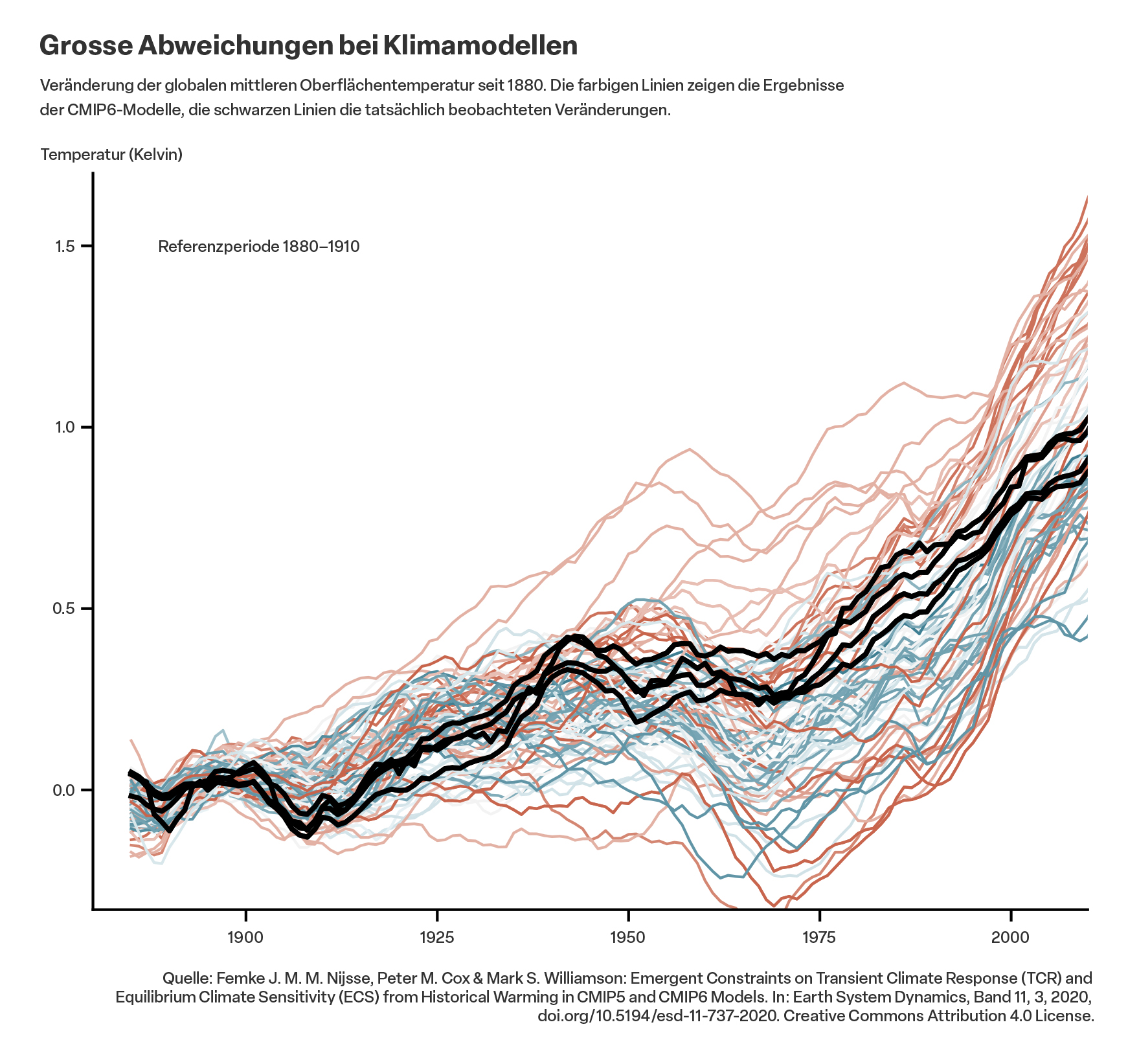

Die Unzulänglichkeiten der Modelle werden noch deutlicher, wenn es darum geht, wie gut sie die beobachteten Klimaveränderungen wiedergeben. Die Abbildung zeigt die von 34 CMIP6-Modellen berechneten Temperaturveränderungen von 1880 bis heute; die Kurven entsprechen den einzelnen Modellen. Die Tatsache, dass nur sehr wenige, wenn überhaupt, mit den beobachteten Veränderungen übereinstimmen (schwarze Linien), deutet auf Fehler in den Modellrückkopplungen oder in den relativen Empfindlichkeiten gegenüber wärmenden Treibhausgasen und kühlenden anthropogenen Aerosolen oder auf das Vorhandensein schlecht beschriebener natürlicher Schwankungen hin.

Die gängige Meinung ist, dass die Modelle alle übereinstimmen. Das ist aber keineswegs der Fall. Vergleiche zwischen den Modellen innerhalb dieser Ensembles zeigen, dass die Modellergebnisse auf den Skalen, die zur Messung der Reaktion des Klimas auf menschliche Einflüsse erforderlich sind, sowohl untereinander als auch von Messungen drastisch abweichen. Aber das weiss man nicht, wenn man sich nicht eingehend mit dem IPCC-Bericht befasst. Wenn man das täte, würde man feststellen, dass es sich bei den vorgelegten Ergebnissen um «Durchschnittswerte» von Modellen handelt, die in krassem Widerspruch zueinander stehen. (Übrigens ist die Unstimmigkeit zwischen den einzelnen Modellen des Ensembles ein weiterer Beweis dafür, dass Klimamodelle mehr sind als «nur Physik». Wäre dies nicht der Fall, wären mehrere Modelle nicht notwendig, da sie alle zu praktisch denselben Schlussfolgerungen kommen würden.)

Die Projektionen regionaler Klimaveränderungen sind das Wichtigste, wenn es darum geht, die Auswirkungen menschlicher Einflüsse und unsere Fähigkeit, sich daran anzupassen, zu beurteilen. Hier sind unsere Kompetenzen, zumindest nach Ansicht führender Wissenschafter,3 am schwächsten: «… für viele wichtige Anwendungen, die regionale Klimamodelle erfordern, oder für die Bewertung grossräumiger Veränderungen aufgrund kleinräumiger Prozesse sind wir der Meinung, dass die derzeitige Generation von Modellen für diesen Zweck nicht geeignet ist.» In der Tat: Die Zahlen im jüngsten IPCC-Bericht zeigen, dass wir für viele Länder nicht einmal feststellen können, ob es in Zukunft mehr oder weniger Niederschlag geben wird als heute.

Das Beste, das wir haben

Bei der Klimamodellierung gibt es eine Menge zu bedenken. Abgesehen von der rechnerischen Herausforderung von Simulationen, die selbst auf den schnellsten Computern der Welt Monate dauern können, muss man sich mit der Unklarheit der Parameterabstimmung, schlecht quantifizierten natürlichen Schwankungen und Komplikationen wie dem Konflikt zwischen der Erwärmung durch Treibhausgase und der Abkühlung durch Aerosole auseinandersetzen. Kein Wunder, dass wir nicht genau wissen, wie das Klima auf steigende Treibhausgaskonzentrationen reagieren wird. Je mehr wir über das Klimasystem lernen, desto mehr erkennen wir, wie kompliziert es ist.

Klimamodelle werden immer ausgefeilter (feinere Gitter, ausgefeiltere Annahmen für Teilgitter) – wie die Computer immer leistungsfähiger werden –, aber nicht unbedingt genauer bei der Beschreibung der Klimareaktion. Die Anwendung von Methoden der künstlichen Intelligenz zur Beschreibung von Untergitterphänomenen ist ein derzeit vielversprechender Forschungszweig. Und was sicherlich helfen wird, sind bessere Beobachtungen des Klimasystems, insbesondere der Tiefen des Ozeans.

«Klimamodelle werden immer ausgefeilter – wie die Computer immer leistungsfähiger werden –, aber nicht unbedingt genauer

bei der Beschreibung der Klimareaktion.»

Wie in den Berichten selbst immer wieder festgestellt wird, sind die Modelle die besten, die wir haben, und sie werden immer ausgeklügelter. Aber sie sind voll von Problemen. Wie alle anderen wünschte auch ich, sie wären besser.

Dieser Text stammt aus Steven E. Koonins Buch «Unsettled: What Climate Science Tells Us, What It Doesn’t, and Why It Matters», 2. Auflage, veröffentlicht im Juni 2024.

Thorsten Mauritsen et al.: «Developments in the MPI-M Earth System Model Version 1.2 (MPI-ESM1.2) and Its Response to Increasing CO2». In: Journal of Advances in Modeling Earth Systems, 11, 998–1038; 13. Januar 2019. doi.org/10.1029/2018MS001400. ↩

Das Coupled Model Intercomparison Project (CMIP) koordiniert weltweit Klimamodellsimulationen als Teil des Weltklimaforschungsprogramms (WCRP). Ziel des CMIP ist es, vergangene, gegenwärtige und zukünftige Klimaveränderungen in einem Multi-Modell-Kontext besser zu verstehen und vorherzusagen. ↩

Tim Palmer & Bjorn Stevens: «The Scientific Challenge of Understanding and Estimating Climate Change». In: Earth, Atmospheric, and Planetary Sciences, 2. Dezember 2019. ↩